ZebraPose: Präzise kamerabasierte Schätzung von Objektlage und -zustand für XR- und Robotik-Anwendungen

Extended Reality (XR) und Robotik sind zwei der Hauptanwendungsgebiete von 3D-Computer Vision. In vielen XR-Anwendungen müssen Position und Lage eines Objekts mit hoher Präzision bestimmt werden. In ähnlicher Weise ist das Greifen und Manipulieren von Objekten für viele Roboteranwendungen erforderlich, die ebenfalls genaue Informationen über die Objektlage erfordern.

Die Schätzung der Objektlage, insbesondere die Variante, die auf synthetischen Daten aus CAD-Modellen trainiert wurde, ist ein Schlüsselthema für viele industrielle Anwendungen.

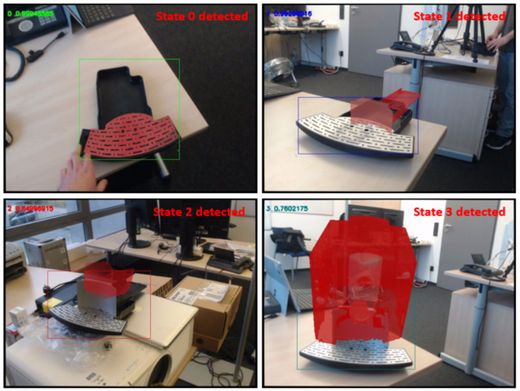

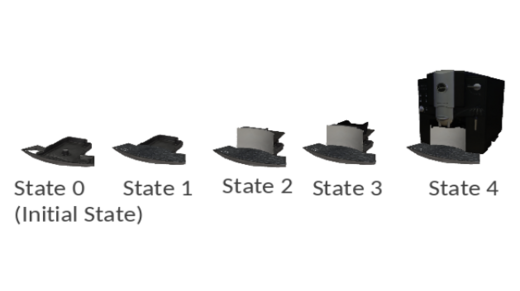

Einer der begehrtesten Anwendungsfälle in diesem Zusammenhang ist die Bereitstellung von Montage- oder Wartungsanweisungen für Industrie- oder Haushaltsgeräte. Ein Objekt kann jedoch während des Montageprozesses verschiedene Zustände einnehmen. Daher ist die Erkennung dieser Objektzustände aus Kamerabildern wichtig.

Beispiele hierfür sind Objekte mit verstellbaren oder abnehmbaren Teilen oder Objekte, die aus mehreren Komponenten bestehen. Solche Objekte sind in realen Situationen zu Hause oder in industriellen Umgebungen sehr häufig anzutreffen und sind für XR- und Roboteranwendungen von großem Interesse.

ZebraPose ist ein hochmodernes KI-System, das auf CAD-Objektdaten trainiert wurde, um die Position von Objekten aus einem einzigen Kamerabild (RGB) zu bestimmen. Es wurde auf der CVPR-Konferenz 2022 veröffentlicht und hat mehrere Preise bei Wettbewerben zur Schätzung der Objektlage gewonnen (BOP Challenge 2022).

ZebraPose übertrifft den Stand der Technik bei RGB-basierten Methoden mit großem Vorsprung. RGB-D-basierte Methoden sollten bei der Merkmalsextraktion von Objekten mit Hilfe von Tiefenbildern einen größeren Vorteil haben. Selbst in diesem Fall übertreffen die Ergebnisse von ZebraPose viele RGB-D-basierte Methoden. Für die Zustandsvorhersage verwenden wir einen CNN-Zweig (Convolutional Neural Network), der mehrere Zustände erkennen und regressieren kann.

Zusammen ergibt dies einen ganzheitlichen Ansatz mit den folgenden Vorteilen:

- 6 Freiheitsgrade Pose aus einem einzigen RGB-Bild

- Nur mit synthetischen Bildern trainiert

- Echtzeit für AR-Anwendungen

Diese Forschungsarbeit wurde im Rahmen des HumanTech-Projekts durchgeführt. Dieses Projekt wurde von der Europäischen Union im Rahmen des Forschungs- und Innovationsprogramms Horizon Europe unter der Fördervereinbarung Nr. 101058236 gefördert.

DFKI.AI Day

Kontakt

Dr.-Ing. Jason Rambach

Forschungsbereich Augmented Vision

Jason_Raphael.Rambach@dfki.de

Tel.: +49 631 20575 3740

Praveen Annamalai Nathan

Forschungsbereich Augmented Vision

Praveen.Nathan@dfki.de

Tel.: +49 631 20575 5352

Sai Jeevanandam

Forschungsbereich Augmented Vision

Sai_Srinivas.Jeevanandam@dfki.de