Immersive Quantified Learning Lab

Assoziierte Projekte

MEDIUS

Multi-Ebenen gekoppelte Laserproduktionstechnologie mit KI-basierter Entscheidungsplattform

Im Projekt MEDIUS vereint sich ein ambitioniertes Konsortium aus den Bereichen Lasertechnologie, Künstlicher Intelligenz, Mensch-Maschine Interaktion, Datenkommuni-kation und Oberflächenmesstechnik mit der Vision, eine disruptive Laserfertigungs-Technologie basierend auf Direkter Laserinterferenz unterstützt durch Augmented Reality (AR) mit einer KI-basierten, lernenden Expertenplattform zu koppeln.

Das Ziel ist die vollständige Steuerung von Laserprozesstechnik mit Hilfe von KI-basierten intuitiven Mensch-Maschine Schnittstellen im Kontext einer lernenden Produktionsplattform zur Funktionalisierung von Oberflächen.

Dies führt zu

- einer signifikanten Vereinfachung und verbesserten Transparenz sowohl der Maschinenbedienung und -nutzung als auch der Verfahrensführung

- einer erhebliche Reduzierung der Design- und Entwicklungszeit für funktionale Oberflächen um 50 % - 60 %

- einer Verkürzung der Anlaufzeit durch das Wegfallen das täglichen Kalibrierung

- einer verbesserte Sicherheit und Stabilität des Fertigungsverfahren durch das Verringern der Arbeitslast des Maschinenbedieners

- Verringerung der Einarbeitungszeit neuer Anwender

- verbesserte Maschinen- und Verfahrenszuverlässigkeit.

Der Beitrag von iQL ist hierbei die Messung der kognitiven Belastung der Arbeitenden, die Erfassung des aktuellen kognitiven Zustandes und die darauf aufbauende automatische Anpassung der mit AR erzeugten Einbledungen an die gegebenen Zustände.

KAINE

Knowledge based learning platform with Artificial Intelligent structured content

Das Ziel des Forschungsprojekts KAINE (Knowledge based learning platform with Artificial Intelligent structured content) besteht Vorkenntnisse und Erfahrungen der Teilnehmer/innen besser im Lernverlauf durch KI zu berücksichtigen, sodass diese sich effizienter weiterbilden können.

Die berufsbegleitende Weiterbildung steht zunehmend im Spannungsfeld der familiären und beruflichen Vereinbarkeit, immer kürzeren Weiterbildungszyklen, der Vermittlung von immer komplexerem Wissen, durch komplexere Kompetenzprofile aus einem interdisziplinären Kontext, steigenden Anforderungen an die Lerneffizienz, der Öffnung der Weiterbildung für neue Bildungsbiografien sowie einem nachhaltigen Wissenstransfer in den betrieblichen Alltag. Die bestmögliche Auflösung dieses Spannungsfeldes impliziert einen Auftrag zur Forschung, Entwicklung und Erprobung von intelligenten Lehr-Lernangeboten.

Das Forschungsprojekt KAINE umfasst drei Aspekte im Entwicklungsfeld III, die sich gegenseitig ergänzen und im Zusammenspiel einen großen Mehrwert für den Lehr-Lernprozess in der beruflichen Weiterbildung versprechen. Zum einen die algorithmenbasierte Individualisierung des Lernprozesses, umgesetzt durch Methoden der Künstlichen Intelligenz, und der Learning Journeys (Curriculum) durch die Verwendung von Nutzenden- und Nutzungsdaten zur Clusterung (Branche, Vorkenntnisse, berufliche Erfahrung) in Kombination mit Learning Analytics (Lerngewohnheiten).

Die fast barrierefreie Begleitung des Lernverlaufs durch einen Voice- bzw. Chatbot ermöglicht die zeitlich und räumlich unabhängige adaptive Unterstützung des Lernprozesses. Zur Lernstandsdiagnostik wird der Lernverlauf durch ein geleitetes Interview mit dem Lernendenmodell abgeglichen und ggf. individualisierte Hilfestellungen angeboten. Zudem erfolgt eine breite Adressierung der individuellen Lernbedürfnisse durch spezifisches Zusatzmaterial, welches durch die algorithmenbasierte Strukturierung von unstrukturierten Lernmaterialien zur Verfügung gestellt wird.

Der Wissenstransfer der erlernten neuen Kompetenzen in den Betrieb wird durch ein dialogorientiertes Beratungssystem unterstützt. Für die einzelnen Transfer- und Implementierungsphasen werden spezifische Hilfestellungen angeboten. Durch regelmäßige Befragungen der ehemaligen Teilnehmenden wird der Beratungsprozess kontinuierlich verbessert und die Nachhaltigkeit der beruflichen Weiterbildung erhöht. Die Erprobung der neuen Lernassistenzsysteme erfolgt durch die Praxispartner u.a. in dem berufsbegleitenden Weiterbildungslehrgang „Digitale Transformation. Mitbestimmen. Mitgestalten“ für Betriebsräte.

InCoRAP

Intentionsbasierte kooperative Roboterhandlungsplanung und Werkerunterstützung in Fabrikumgebungen

Das Projekt InCoRAP erforscht die Mensch-Roboter-Interaktion in Fabrikumgebungen unter Berücksichtigung der Intention des Menschen. Dies erlaubt die fließende Interaktion zwischen Mensch und Roboter, da der Roboter erkannte Intentionen des Menschen bereits in seine Handlungen integrieren kann. Bestehende Ansätze zur Unterstützung von Werkern nutzen vergleichsweise wenige Informationen wie die Bewegung des Werkers in der Umgebung, um die Handlungen des Roboters zu adaptieren.

Dies führt oft zu Unterbrechungen der Interaktion, wenn beispielsweise der Roboter noch Handlungen ausführt, die im aktuellen Kontext gar nicht mehr notwendig wären. Dieses grundlegende Problem wird im Projekt InCoRAP gelöst, indem sämtliche Assistenzfunktionalität (einschließlich der Aktionen des Roboters) auf die erkannten Intentionen des Werkers gestützt werden.

Um solche Intentionen abzuleiten, betrachtet das Projekt Sensordaten in Bezug auf die aktuelle Aufgabe des Werkers. Dies erfordert ein umfassendes Modell der Umgebung, das sowohl Informationen aus einer Vielzahl von Sensoren als auch Prozessinformationen aus z.B. einem ERP-System integriert.

Die Erkennung menschlicher Intentionen aus verfügbaren Sensordaten, die Generierung und Pflege eines solchen multisensorischen hierarchischen semantischen Modells der aktuellen Umgebung und deren Verwendung für die Aktionsplanung und situationsgerechte Unterstützung bilden den F&E-Schwerpunkt des Projekts.

HyperMind - Das antizipierende Schulbuch

Das antizipierende Physikschulbuch, das wir im Projekt HyperMind entwickeln, soll zu einem dynamisch-adaptiven persönlichen Schulbuch werden und individuelles Lernen ermöglichen. HyperMind setzt an der Mikroebene des Physikschulbuchs an, die die einzelnen Darstellungsformen, sog. Repräsentationen, eines Schulbuches – wie z. B. den Schulbuchtext mit einem gewissen Anteil an Fachbegriffen, Formeln, Diagrammen oder Bildern – enthält.

Die statische Struktur des klassischen Buches wird aufgelöst. Stattdessen werden der Buchinhalte portioniert und die resultierenden Wissensbausteine assoziativ verlinkt. Zusätzlich werden die Bausteine mit multimedialen Lerninhalten ergänzt, die auf Basis von Aufmerksamkeits(blick-)daten abrufbar sind.

Be-greifen

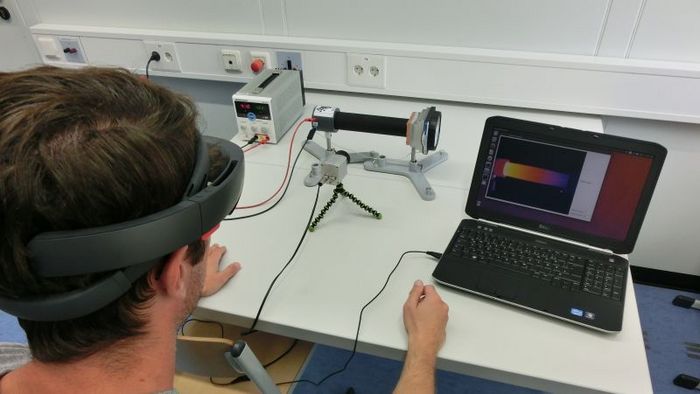

Das Thema dieses Projektes ist die Erforschung innovativer Mensch-Technik-Interaktionen (MTI), die durch Verschmelzung von realer und digitaler Welt (augmented reality) den Zusammenhang zwischen Experiment und Theorie für Lernende des Studiums in MINT-Fächern begreifbar, erfahrbar und in Echtzeit interaktiv erforschbar machen.

ESPEDUCA - JST CREST (in Kooperation mit der Osaka Prefecture University)

Über das Internet kann Wissen geteilt werden. Die meisten Informationen beschränken sich hierbei jedoch auf "explizites Wissen" wie Text und nicht "implizites Wissen", wie die Erfahrung etwas selbst erlebt zu haben. Das Ziel dieses Projektes ist es, diese Erfahrungen mit Hilfe von Sensoren aufzunehmen und ermöglichen anderen diese Erfahrungen zur Verfügung zu stellen.

Eyetifact und GazeSynthesizer (in Kooperation mit der Osaka Prefecture University)

Mit Hilfe von Deep-Learning-Technologien wurde die Verarbeitung von Bildern, Audio und Sprache deutlich beschleunigt. Aktivitätserkennung hat davon noch nicht profitiert, da es schwierig ist auf diesem Gebiet eine große Menge an Daten zum Trainieren des Deep-Learning-Algorithmus zu erhalten. Je sensitiver und komplexer die Sensoren sind, desto schwerer ist es die benötigte Datenmenge zu erhalten. Mit Hilfe von Eyetifact werden Sensordaten aus verschiedenen Quellen kombiniert um mit Hilfe von Deep Learning einen Datensatz zu erstellen, so dass bei der anschließenden Verwendung einzelner Sensoren andere Daten vorhergesagt werden können.

Um die Lesbarkeit von Texten verbessern zu können müssen diese zunächste von einer großen Gruppe von Personen gelesen, die Augenbewegung aufgenommen und diese ausgewertet werden. GazeSynthesizer erzeugt basierend auf den Messungen an wenigen Seiten einen Datensatz und kann mit Hilfe von Deep Learning künstliche Augenbewegungen simulieren um so die Lesbarkeit von unbekannten Texten in Abhängigkeit von Parametern wie Alter oder kultureller Hintergrund simulieren.

SUN - Analyzing student understanding of vector field plots with respect to divergence

Das visuelle Verstehen abstrakter mathematischer Konzepte ist entscheidend für wissenschaftliches Lernen und eine Voraussetzung für das Entwickeln von Expertise. Dieses Projekt analysiert das Verständnis von Studenten beim Betrachten von Vektorfeldern unter Anwendung verschiedener visueller Strategien.

Machen Sie mit!

Raumbuchungen und Events:

Kontaktieren Sie Dr. Nicolas Großmann

Kontakt

Dr. Nicolas Großmann

Tel.: +49 631 20575 5304

nicolas.grossmann@dfki.de

Deutsches Forschungszentrum für

Künstliche Intelligenz GmbH (DFKI)

Forschungsbereich Smarte Daten & Wissensdienste

Trippstadter Str. 122

67663 Kaiserslautern

Deutschland