Das Ziel des Projekts ist es, neue technische und wissenschaftliche Grundlagen für eine soziale und physische KI der realen Welt, insbesondere für eine verbesserte soziale Interaktion mit digitalen Charakteren, zu schaffen. Dafür wird eine immersiv-shared Perfomance Umgebung entwickelt für einen virtuellen Raum oder in einer Mixed-Reality Rekonstruktion.

Um das zu realisieren, wurde der Tanz als Vehikel gewählt, denn diese zutiefst menschliche Aktivität führt durch die Verbindung von Denken, Fühlen, Spüren mit körperlicher Bewegung zu starken positiven Effekten auf das physiologische und psychologische Wohlbefinden.

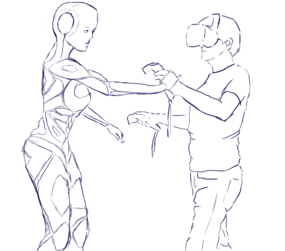

So will Carousel+ KI-gesteuerte Charaktere entwickeln, die mit Einzelpersonen oder Gruppen auf sinnvolle Weise autonom interagieren. Tanzen verbindet körperliche Betätigung mit gesteigerter Sinneswahrnehmung, kognitiven Fähigkeiten, Kreativität, zwischenmenschlichem Kontakt und emotionalem Ausdruck. Daher werden die ersten Anwendungsfälle des Projekts moderne Freiformtanzstile in Gruppen und Paaren, Volkstänze und Partnertänze wie Tango beinhalten. Die besondere Herausforderung bietet die komplexe Abhängigkeit zwischen Bewegung, Musik, taktilem Kontakt und den Gefühlen der TänzerInnen.

Carousel+ gehört zu dem neuen Zweig der „Real-World Social and Physical AI“, mit vielen neuen Anwendungsbereichen wie Soziales, Unterhaltung, Gesundheit, Bildung, Sicherheit, Friedensschaffung, Notfallhandhabung und Autonomes Fahren.

Der Forschungsbereich Agenten und Simulierte Realität (ASR) des DFKI, unter Leitung von Prof. Dr. Philipp Slusallek, entwickelt die Technologie für die intelligente Simulation und Steuerung von physisch plausiblen, virtuellen Charakteren. Zur Erzeugung von qualitativ hochwertigen animierten Inhalten werden Signale von mehreren Personen in Echtzeit interpretiert, um eine nahtlose und einnehmende visuelle Erfahrung während des Tanzes zu erreichen. Für die Animation des virtuellen Charakters wird ein Charakter-Controller aus der aktuellen Szene und der Benutzeranalyse generiert. Durch spezielle maschinelle Lernmodelle können verschiedene Bewegungstypen für verschiedene Tänze entwickelt werden. Zur Erhöhung des Realismus sollen die Charaktere intrinsisch arbeiten und aus ihren Erfahrungen lernen. Für den speziellen Fall der Unterrichtsszenarien werden visuelle und haptische Feedbacks mit einem Agenten-Controller integriert.

Für weitere Informationen besuchen Sie die Projektwebseite.

Partner

Grassroots Arts and Research, Edinburgh Napier University, Aalto University, VIVITnet

Prof. Dr.-Ing. Philipp Slusallek

Prof. Dr.-Ing. Philipp Slusallek