Foundation Models kommen in vielen verschiedenen Bereichen zum Einsatz. Sie unterstützen sogar kritische Sektoren wie das Gesundheitswesen, die öffentliche Sicherheit und das Bildungswesen. Mit ihrer zunehmenden Bedeutung wird auch ihre Sicherheit immer wichtiger. Forschungsergebnisse deuten jedoch darauf hin, dass sich Foundation Models unbeabsichtigt Informationen aus ihren Trainingsdaten merken können. Dies kann dazu führen, dass sensible persönliche Daten, urheberrechtlich geschützte Inhalte und vertrauliche oder geschützte Informationen nach außen dringen.

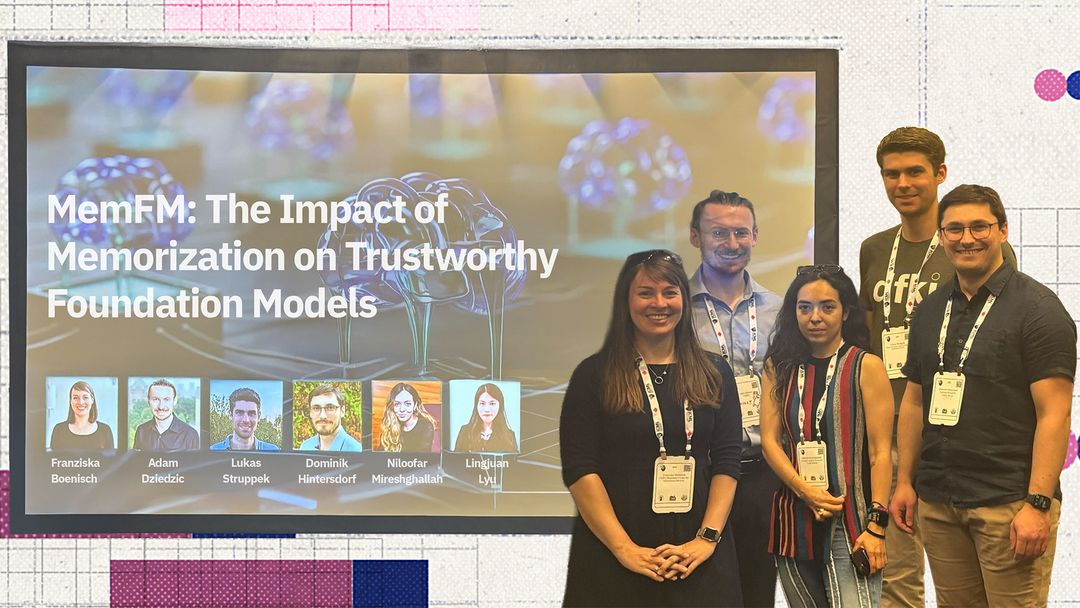

Um den Austausch in diesem Bereich der Forschung zu fördern haben Dominik Hintersdorf und Lukas Struppek aus dem Forschungsbereich „Grundlagen der Systemischen KI” am DFKI in Darmstadt gemeinsam mit anderen Forschenden den Workshop „The Impact of Memorization on Trustworthy Foundation Models” auf der ICML organisiert. Im Workshop wurden die Herausforderungen, die sich durch Erinngerungseffekte ergeben, aus verschiedenen Perspektiven beleuchtet und Ursachen, Folgen und mögliche Maßnahmen diskutiert. Ziel war es, die Entwicklung von Foundation Models zu unterstützen, von denen die Gesellschaft profitiert, ohne dass dabei die Privatsphäre, das geistige Eigentum oder das öffentliche Vertrauen gefährdet werden.

Hintersdorfer und Struppek sowie ihre Mitorganisator*innen Franziska Boenisch (CISPA Helmholtz-Zentrum für Informationssicherheit), Adam Dziedzic (CISPA Helmholtz-Zentrum für Informationssicherheit), Lingjuan Lyu (Sony AI), Niloofar Mireshghallah (FAIR/CMU) und konnten Referenten wie Kamalika Chaudhuri (USCD/Meta), A. Feder Cooper (Yale University/Microsoft), Vitaly Feldman (Apple), Pratyush Maini (Carnegie Mellon University) und Reza Shokri (National University of Singapore) gewinnen. Amy Beth Cyphert (West Virginia University College of Law), Casey Meehan (OpenAI) und Om Thakkar (OpenAI) nahmen an einer Podiumsdiskussion teil. Der Workshop wurde vom CISPA Helmholtz-Zentrum für Informationssicherheit gesponsert.

Mehr Informationen über das DFKI auf der ICML: https://dfki.de/web/news/icml-2025-truegerische-erklaerbarkeit-in-ki-systemen