Die Forschungsarbeiten in DEEPLEE, die im Forschungsberich Sprachtechnologie in Saabrücken und Berlin durchgeführt werden, bauen auf der Expertise des DFKI in den Bereichen "Tiefes Lernen" (DL) und "Sprachtechnologie" (LT) auf und entwickeln sie weiter. Sie streben profunde Verbesserungen von DL-Ansätzen in LT an, indem sie vier zentrale, offene Forschungsthemen thematisieren:

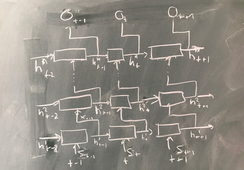

- Modularität in DNN-Architekturen

- Nutzung von externem Wissen

- DNNs mit Erklärungs-Funktionalität

- Maschinelle Lehr-Strategien für DNNs

Das Resultat der Forschungsarbeiten wird ein DL-basiertes modulares Rahmensystem sein, das End-to-End-Anwendungen in Informationsextraktion (IE), Fragebeantwortung (Question Answering, QA) und maschineller Übersetzung (MÜ) ermöglicht. Dabei werden folgende Forschungsziele verfolgt:

- Komplexe LTs (IE, QA, MÜ), die traditionell auf heterogenen Technologie-Sammlungen beruhen, sollen als einheitliche auf neuronalen Netzwerken basierende End-to-End-Lernszenarien modelliert werden.

- Die End-to-End-Performanz klassischer, auf heterogenen Technologie-Sammlungen beruhenden Ansätze soll gegen neuronale Ansätze evaluiert werden.

- Ein Repertoire von "linguistisch inspirierten" neuronalen Bausteinen für LTs soll etabliert werden, die sprachagnostisch sind und wiederverwendet werden können (einschließlich erläuternder Funktionalität und Lernaspekte wie unterschiedliche Grade der Überwachung, Modellverteilung, Transfer Lernen, Multi-Task-Lernen für solche Module) . Wir werden dies für IE-, QE- und MÜ-Szenarien tun, die eine breite Palette von Bausteinen und Anwendungen abdecken.

- Es soll ein Portfolio von Ansätzen für eine Vielzahl von DNNs und Aufgaben (NMÜ, NQA und NIE) etabliert werden, die sich einem menschlichen Experten zu erklären vermögen.

- IE, QA und MÜ sollen als Text-to-Text-Anwendungen gestaltet werden.

- Entwicklung und Bewertung von Möglichkeiten zur Integration externer Wissensquellen in NN-basierte LTs.